Vision Transformers for Dense Prediction

ABSTRACT

本文方法和创新点

提出使用稠密vision transformers在卷积网络中作为backbone进行稠密估计任务

将vision transformer不同阶段的token组合为不同分辨率的类图像表示,并在过程中利用卷积解码器将他们组合为全像素的预测。

实验效果提升

在每一个阶段都有全局感受野,相较于全卷积网络能提供更细粒度以及全局更有条理的预测结果。

在单目深度估计任务,相比于先进的全卷积网络,相对性能上提高了28%

对于语义分割任务,在ADE20K上达到了新的先进水平,49.02%mIoU。

也能够在更小的数据集上进行细化,达到先进水平。

INTRODUCTION

问题:

backbone的选择很重要,在encoder中损失的信息不可能在decoder中恢复

在稠密预测任务中,下采样具有显著的缺点:在模型的更深的阶段,特征分辨率和粒度会丢失,很难在decoder中恢复

目前解决方法:

在更高的输入分辨率上训练

膨胀卷积

在encoder和decoder之间设置跳接

练剑多分辨率的表示通过网络

本文提出(创新点)

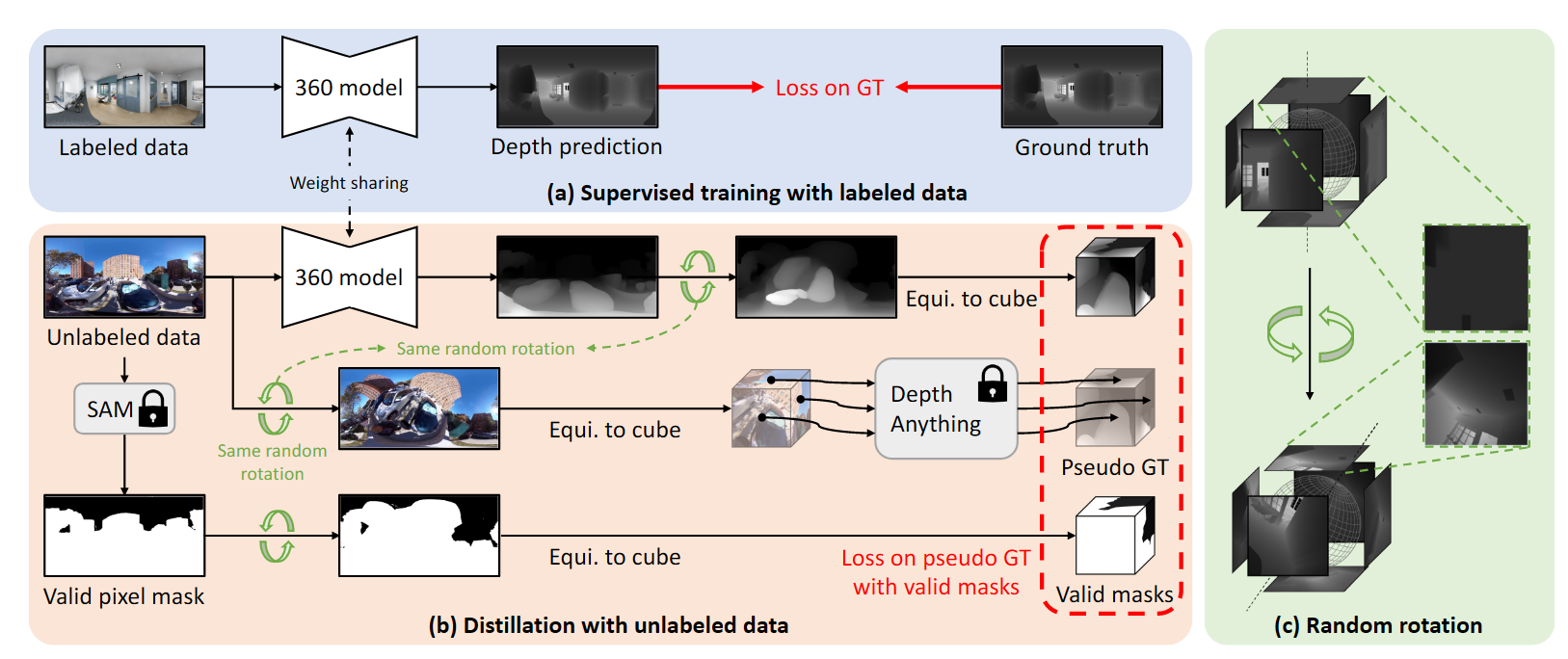

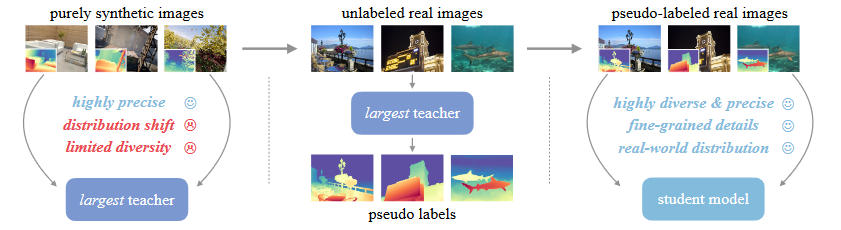

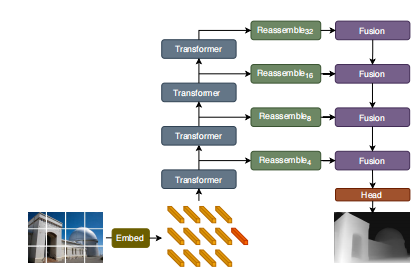

①提出稠密估计transformer,使用transformer作为encoder的基本计算构建块,使用ViT作为backbone结构

② 将vision transformer不同阶段的token组合为不同分辨率的类图像表示,并在过程中利用卷积解码器将他们组合为全像素的预测。

③在计算图像embedding之后抛弃了下采样操作,而在整个处理阶段都报纸了同样维度的表示

PROPOSED METHOD

模型结构

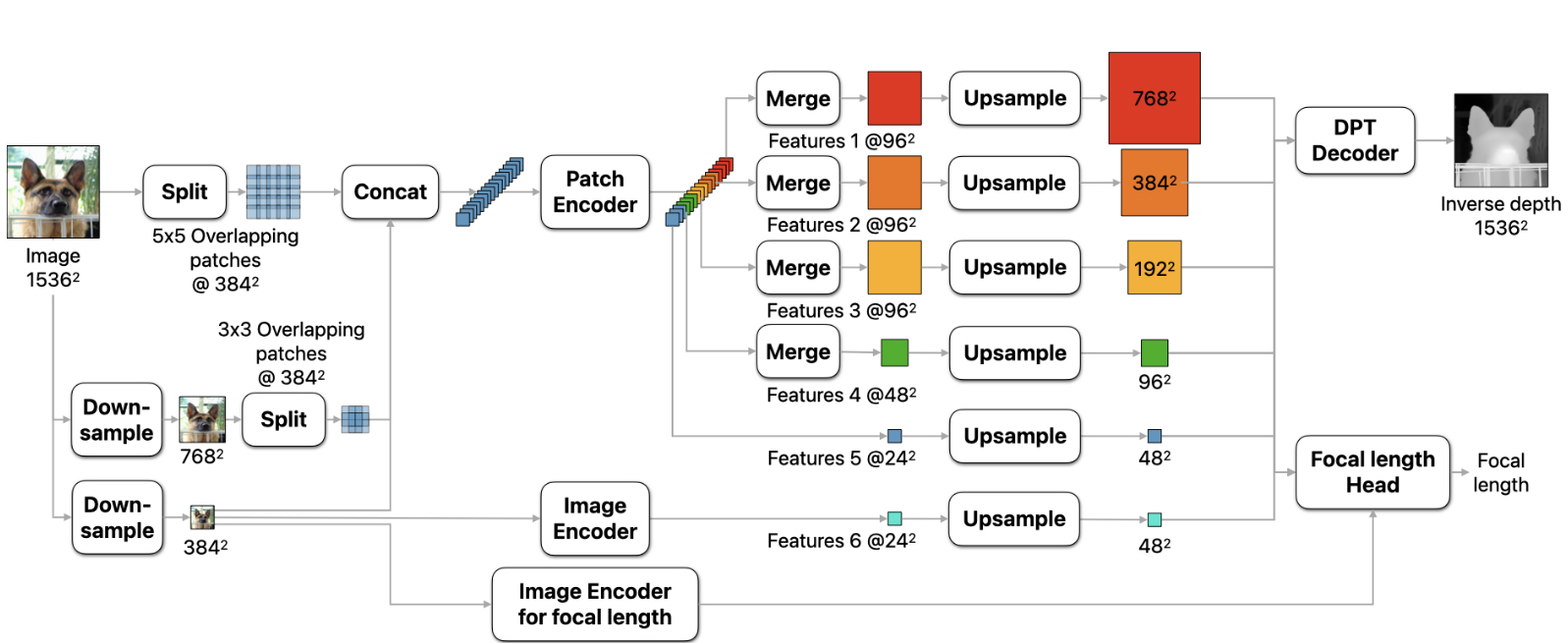

模型分解—1:Transformer encoder

在所有的计算中保持了token的数量不变,能够在所有transformer阶段保持初始embedding的空间分辨率

用一个ResNet50对图像提取embedding,并将得到的特征图的特征作为token

采用一个readout token用于分类

三种变体:ViT-Base ViT-Large ViT-Hybrid

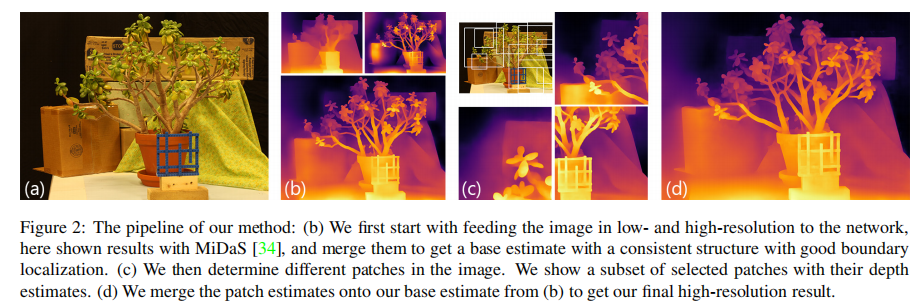

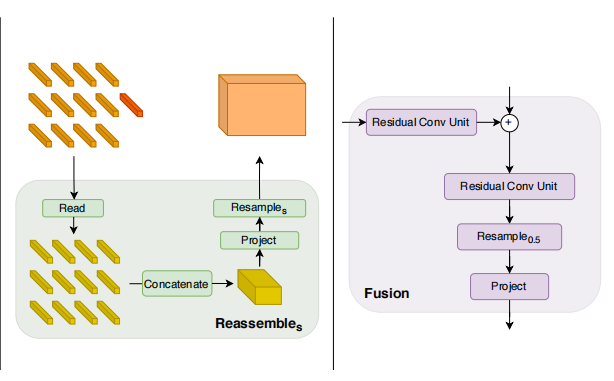

模型分解—2:Convolutional decoder

Reassemble operation

在将表示投影到原始特征维度D之前,使用一个线性层和GELU非线性,使readout和其他所有token连接在一起传递信息

使用一个RefineNet-based的特征融合块,并在每个阶段逐步上采样两倍