D4D: An RGBD diffusion model to boost monocular depth estimation

发表于|更新于|深度估计

|总字数:286|阅读时长:1分钟|浏览量:

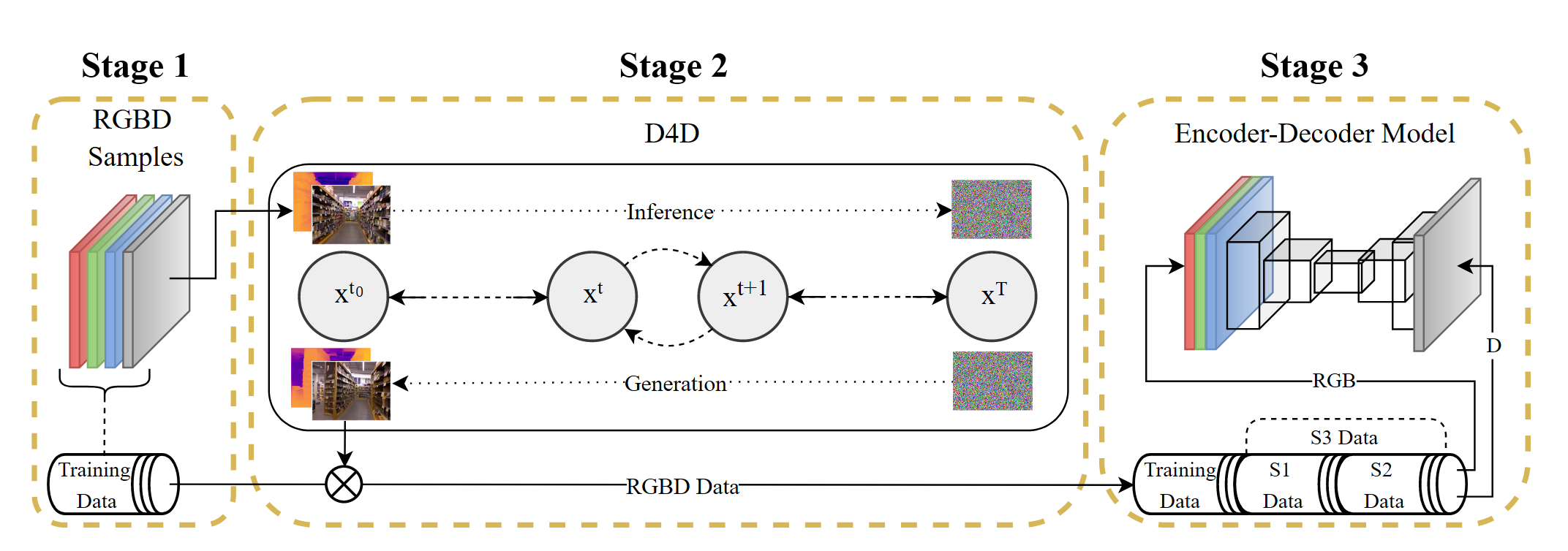

方法

阶段一

对NYU和KITTI中的RGBD样本进行预处理,进行归一化以及rescale,分辨率跟第三阶段所采用的model有关

阶段二

第二阶段对输入的RGBD进行前向和后向操作训练网络,同时通过S1和S2两种不同的训练配置,得到不同的生成数据,其中$S1$使用$L1$ loss,$β$策略采用线性策略,$S2$使用$L2$ loss,$β$采用余弦策略

最终得到的$S3$就是$S1$和$S2$的并集

最终用于后续训练的增强训练数据集由$S3$和原始的训练数据组成

阶段三

用构建的增强训练数据集对多个model进行训练

相关推荐

2024-12-08

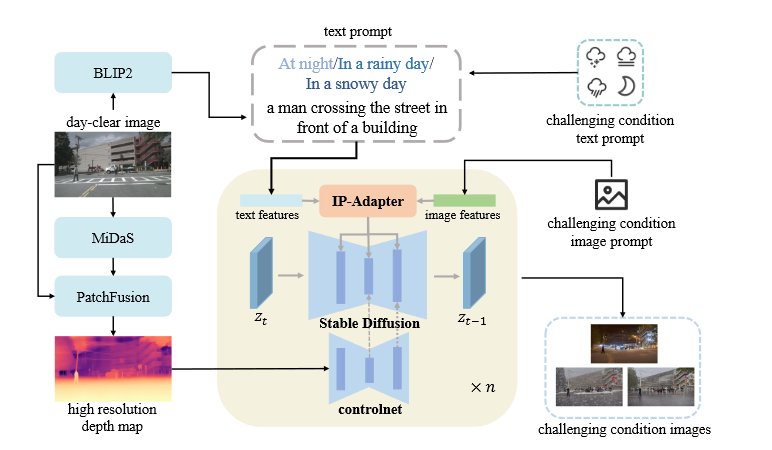

SSD:Stealing Stable Diffusion Prior for Robust Monocular Depth Estimation

背景现有的MDE方法在标准的环境下(例如晴天)表现的很好,但是在一些具有挑战性的条件下效果会变得很差,这主要是由于一些关键的假设失效了,例如光度一致性假设,同时也没有可靠的ground truth包含这些场景。 现有的一些鲁棒的解决方案 基于模型的方法 这一方法通过修改网络结构来增强模型处理各种条件的能力 缺点:网络模型过于复杂,不能够适应各种环境 基于数据的方法 利用域自适应或其他模态的数据来增强图像信号 缺点:缺乏高质量的数据,需要后处理 方法Generative Diffusion Model-based Translation生成在深度方面与白天清晰图像非常相似的训练样本 I_{g}=S D ( I P ( T_{p}, I_{p} ), C N ( D_{h} ), z ) BILP2:获取场景描述符,保留图像内容信息 ControlNet d2i:保持近似深度一致性 MiDas:获取初始深度图 PatchFusion:获得高分辨率的深度图 text prompt=BILP2 场景描述符+challenging condition...

2024-12-08

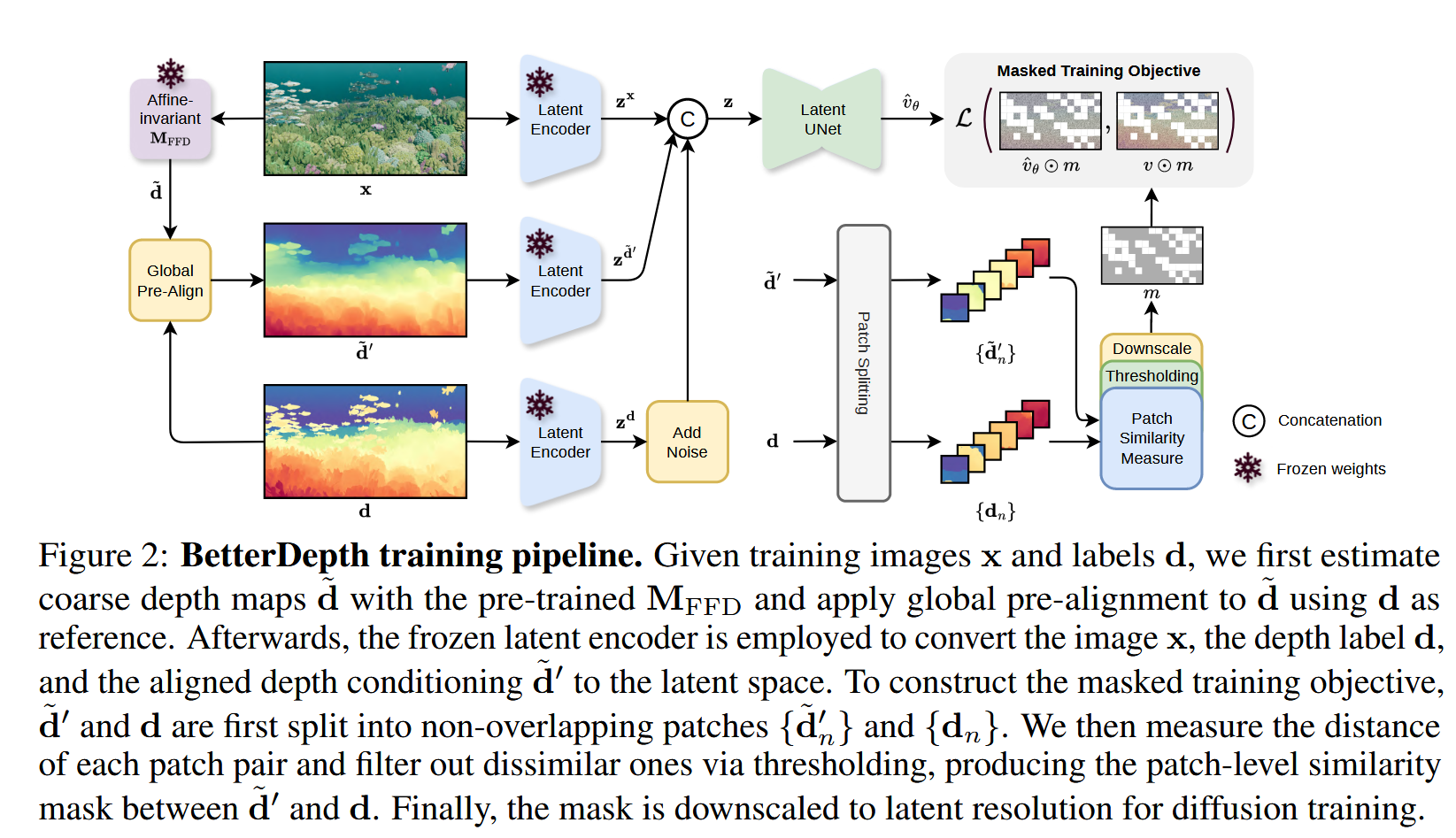

BetterDepth: Plug-and-Play Diffusion Refiner for Zero-Shot Monocular Depth Estimation

Problem Formulationfeed-forward model: {\cal L}_{\mathrm{M D E}} ( {\bf d}_{i}, {\bf M}_{\mathrm{F F D}} ( {\bf x}_{i} ) ), \tag{1}Diffusion model: {\cal L}_{\mathrm{D M}} \left( \epsilon, {\bf M}_{\mathrm{D M}} \left( {\bf x}_{i}, \mathrm{A d d N o i s e} ( {\bf d}_{i}, \epsilon, t ) \right) \right), \tag{2}Framework Global Pre-Alignment给定预训练仿射不变深度模型$\bf{M}_{FFD}$ 和数据对$\bf{(x, d)} ∈ \bf{D}_{syn}$...

2024-12-06

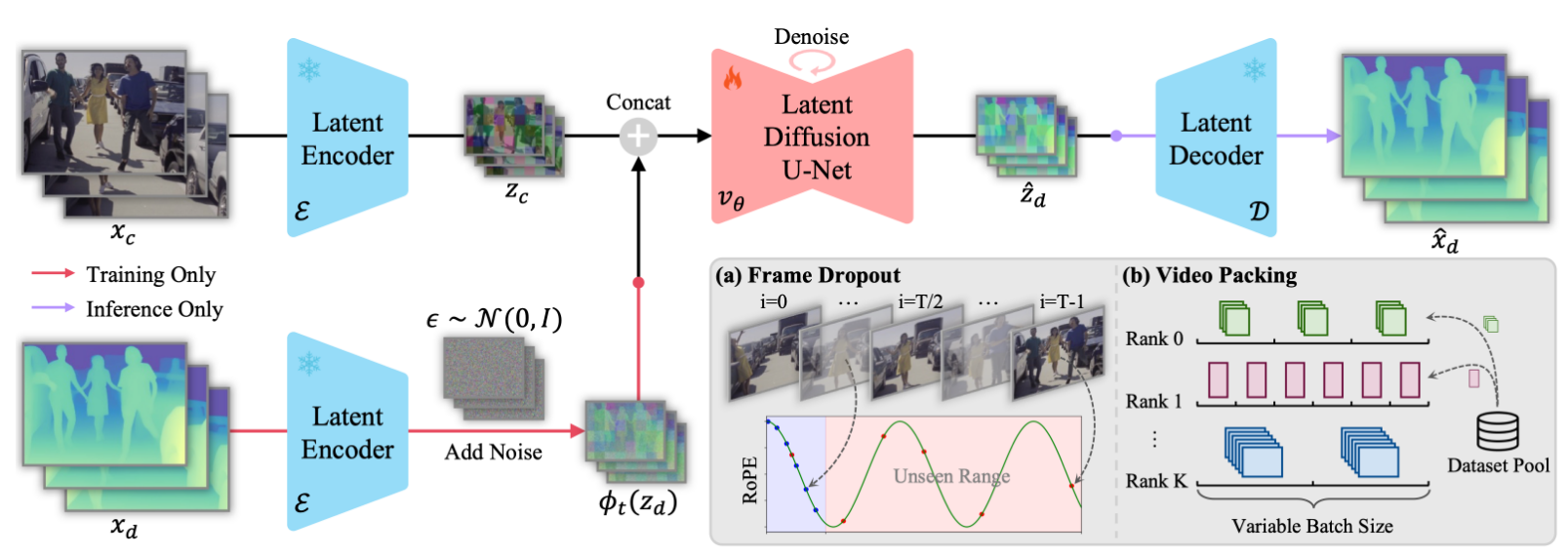

DEPTH ANY VIDEO WITH SCALABLE SYNTHETIC DATA

构建合成视频数据集在不同的虚拟环境中,利用synthetic engines获取深度信息,构建了一个包含40000个视频切片的数据集,涵盖室内外场景。 在部分的图像和深度图之间可能存在不对齐的现象,首先采用 scene cut 方法,根据显著颜色变化检测场景的转变,然后用深度模型去滤除掉那些指标低的视频序列。 直接过滤指标低的视频序列可能会对导致过滤到一些网络没有见过的数据,因此,进一步使用 CLIP 来计算真实深度和预测深度之间的语义相似性。 最终方法是对每个视频序列均匀采样10帧,如果语义和深度的指标都低于预先定义的阈值,就滤除该片段 生成视频深度模型模型设计 训练和推理的过程与其他基于diffusion 的model保持一致。采用和Marigold一样的归一化方法。 \tilde{x}_{d}=\left( \frac{x_{d}-d_{2}} {d_{9 8}-d_{2}}-0. 5 \right) \times2, \tag{1}由于在时间维度上进行压缩会导致运动模糊伪影,所以只在空间维度上进行压缩。 将latent video和latent...

2024-12-06

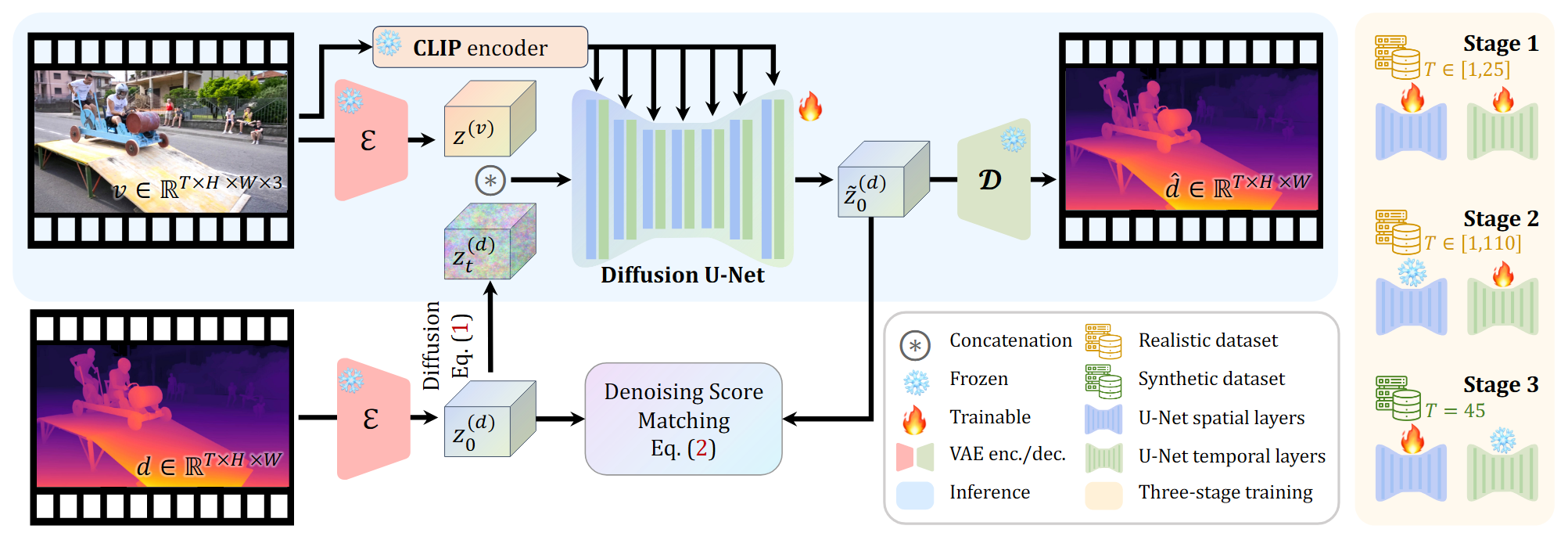

DepthCrafter

方法 将视频深度估计定义为一个条件扩散生成问题,对条件分布 $p({d}|v)$ 进行建模 采用成对的真实与合成数据集对网络进行三阶段的训练 对长序列进行分段估计并无缝拼接 Stable video diffusion model \mathbf{x}_t = \mathbf{x}_0+\sigma_t^2\epsilon,\quad \epsilon\sim \mathcal{N}(0, \mathbf{I})\tag{1} \mathbb{E}_{\mathbf{x}_t \sim p(\mathbf{x};\sigma_t),\sigma_t \sim p(\sigma)} \left[ \lambda_{\sigma_t} \left\|D_{\theta}(\mathbf{x}_t; \sigma_t; c) - \mathbf{x}_0 \right\|^2_2 \right] \quad \tag{2} D_\theta (\mathbf{x}_t; \sigma_t; \mathbf{c})...

2025-02-27

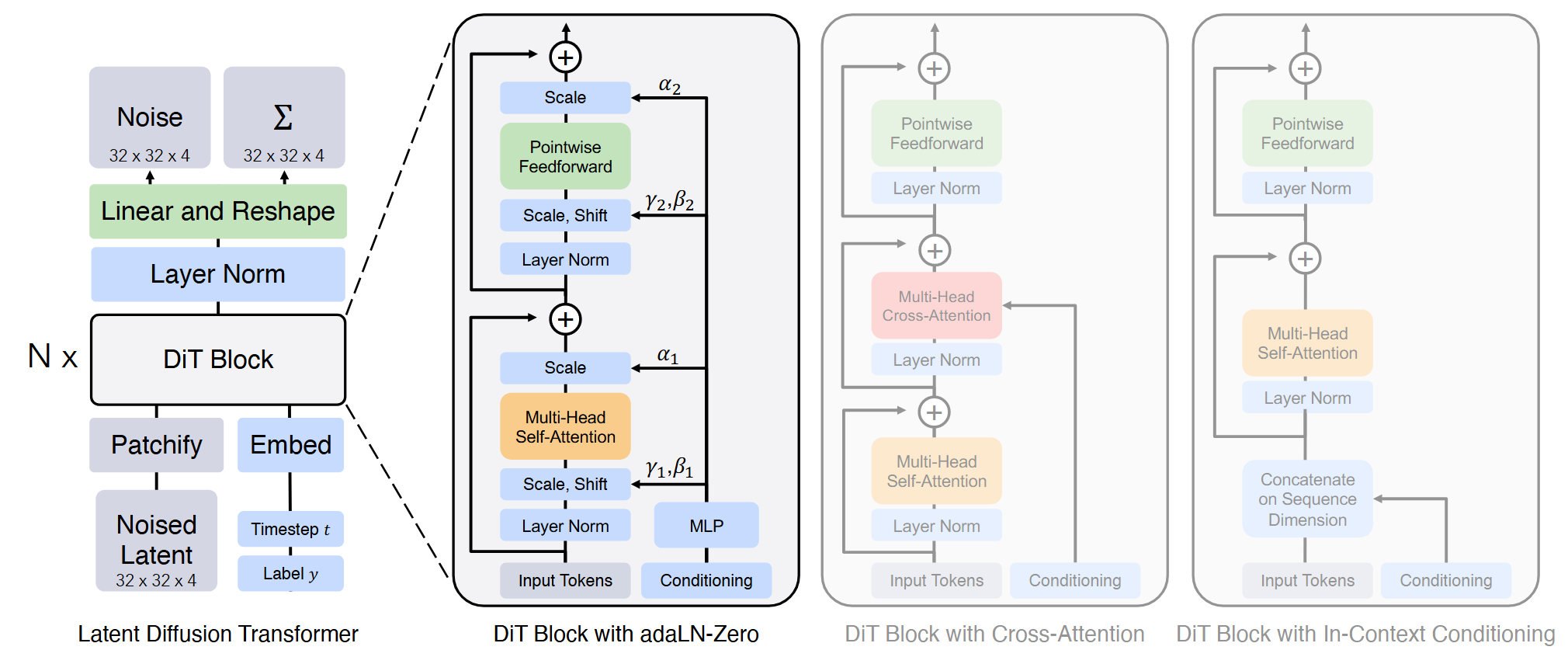

Scalable Diffusion Models with Transformers

摘要基于transformer结构构建了一类新的扩散模型,DiT。即使增加transformer的深度/宽度或者增加输入tokens的数量,依旧能够保持更低的FID。最大的DiT-XL/2模型在ImageNet 512×512和256×256基准上性能优于所有先前的扩散模型,在后者上实现了2.27的FID。 方法预备知识1.扩散模型前向加噪过程:对真实数据逐步添加噪声: x_{0}: q(x_t|x_0)={\cal N} ( x_{t} ; \sqrt{\bar{\alpha}_{t}} x_{0}, ( 1-\bar{\alpha}_{t} ) {\bf I} ) x_{t}=\sqrt{\bar{\alpha}_{t}} x_{0}+\sqrt{1-\bar{\alpha}_{t}} \epsilon_{t}, \quad where\quad\epsilon_{t} \sim{\mathcal{N}} ( 0, \mathbf{I} )对扩散模型进行训练,学习正向加噪过程的反向过程: p_{\theta}\left(x_{t-1} \mid...

2025-02-28

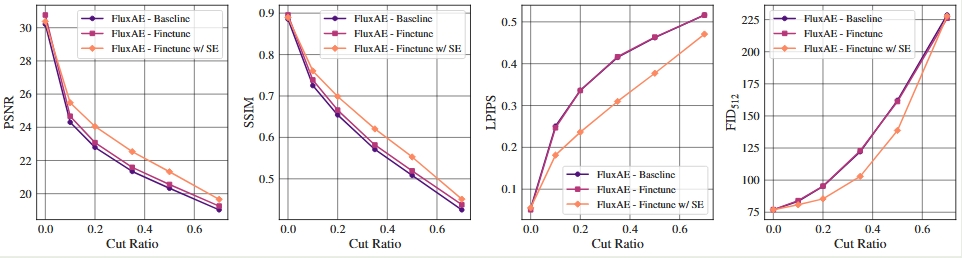

Improving the Diffusability of Autoencoders

摘要鲜有人研究autoencoder和diffusion model之间的相互作用 autoencoder潜在空间中的高频分量会影响diffusion生成过程与质量 提出scale equivariance的正则化策略,在decoder中对潜在空间与RGB空间进行频率对齐 只需要改变较少的代码,20K步autoencoder的微调,就能够提高生成质量 简介Diffusability描述了通过扩散过程对分布进行建模的难易程度:高Diffusability表示分布易于拟合,而低Diffusability则使过程更加复杂 扩散模型鼓励误差累积推迟到频谱的高频部分,但是如果autoencoder的潜在低频部分与RGB空间中的对应部分的对应关系丢失了,就会影响重建的准确性。 现有的autoencoders中的潜在空间中存在突出的高频分量,与RGB信号中的频谱分布存在明显偏离,会影响重建的RGB结果,造成明显的视觉伪影。 标准的KL正则化不足以处理频谱缺陷,甚至可能放大问题。 方法背景:Blockwise 2D DCT给定以为二维信号块...

公告

记录读研过程中学习阅读的相关论文书籍与研究内容。部分前期论文阅读记录格式较乱,请多多包涵。后期会尽量统一论文阅读记录的格式。同时也将更新更多有趣的内容。

最新文章