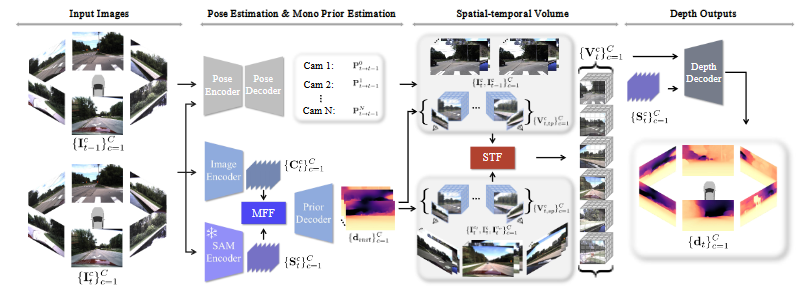

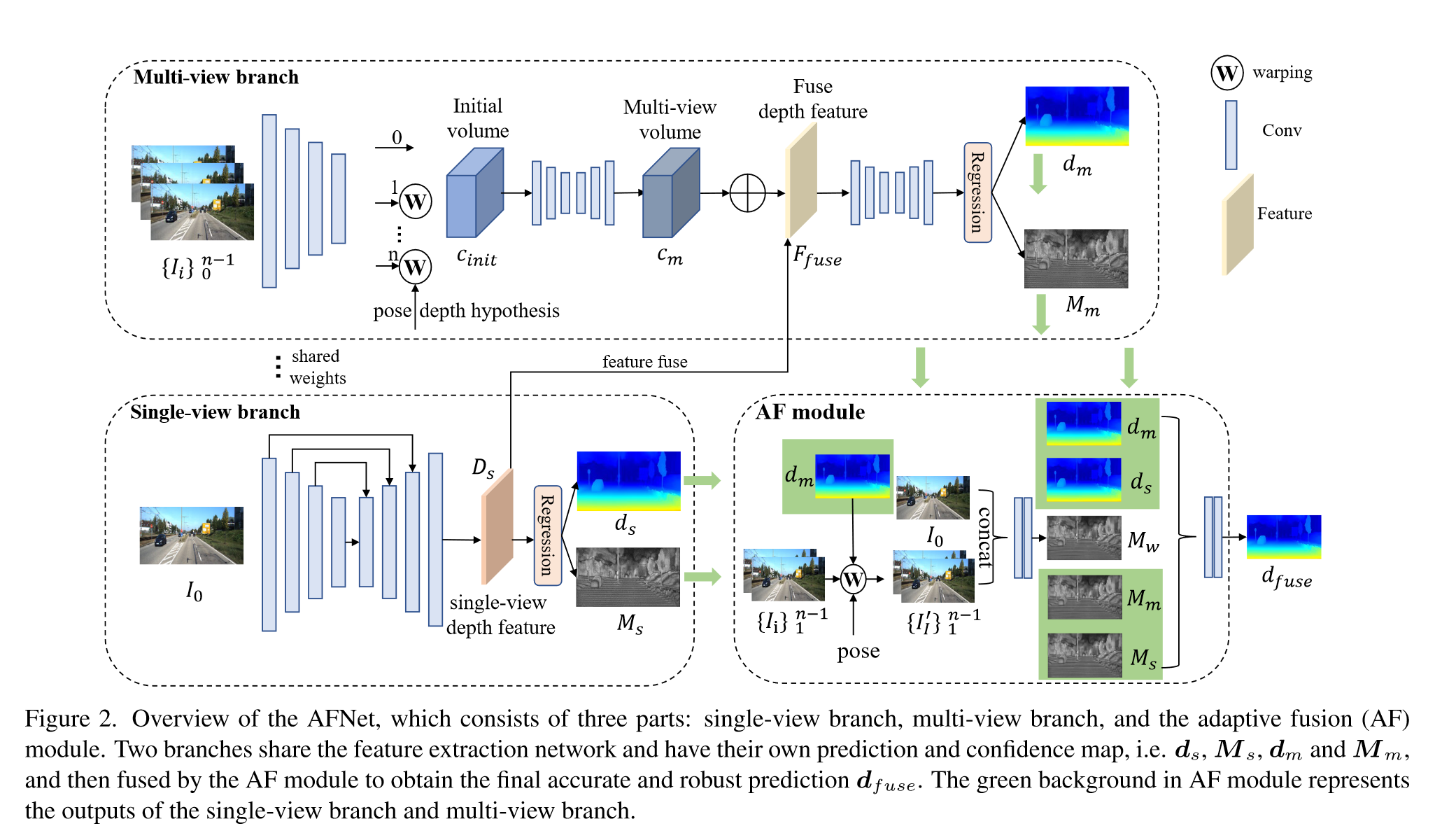

Adaptive Fusion of Single-View and Multi-View Depth for Autonomous Driving

Input: $n-1$ 个源图像 ${I_i}^{n-1}_{i=1}$、参考图像 $I_0$、相机内参和相机姿态

Output:depth $d$

Part:single-view depth module, multi-v iew depth module, adaptive fusion module and pose correction module

Single-view and Multi-view Depth Module

使用ConvNeXt-T作为backbone提取四个尺度上的特,征$F_{ i,l} (l = 1, 2, 3, 4)$,特征维度分别为$C=96,192,384,768$

Single-view branch

采用多尺度的decoder聚合特征获得深度特征$D_s ∈ R^{H/4×W/4×257}$

对$D_s$的前256个通道使用softmax得到depth probability volume $P_s ∈ R^{H/4×W/4×256}$,最后一个通道作为置信度图$M_s ∈ R^{H/4×W/4}$

采用soft-weighted sum计算单目的深度:

where $\Bbb{B}$ denotes the bins uniformly sampled in the log space from $d_{min}$ to $d_{max}$

Multi-view branch

使用同样的backbone获取特征

采用去卷积将低分辨率特征变换为四分之一分辨率,并与 $F_{i,1}$ 结合构建cost volume,通过将源图像的特征warp到参考图像的相机平面构建feature volume,the initial cost volume $C_{init} ∈ R^{H/4×W/4×128}$

使用2D hourglass network进行正则化获得最终的多视角cost volume $C_{m} ∈ R^{H/4×W/4×256}$

将单目深度特征 $D_s$ 与 cost volume融合获得融合深度特征 $F_{fuse}$ :

再通过2D hourglass network以及后续操作得到多视角置信度图和深度预测

Adaptive Fusion Module

采用$M_s$,$M_m$和$M_w$三个置信度图进行融合,前两个是由前面两个分支获得的,第三个是由前向warping获得的。

使用相机位姿和多视角深度图 $d_m$ 作为输入,将源图像warp到参考相机空间,得到 ${ I^{‘}_i }^{n-1}_{i=1}$ 与 $I_0$ 连接:

将三个置信度图作为引导,通过两个卷积层获得融合深度

Loss Funcion

depth loss

confidence loss vaild mask:

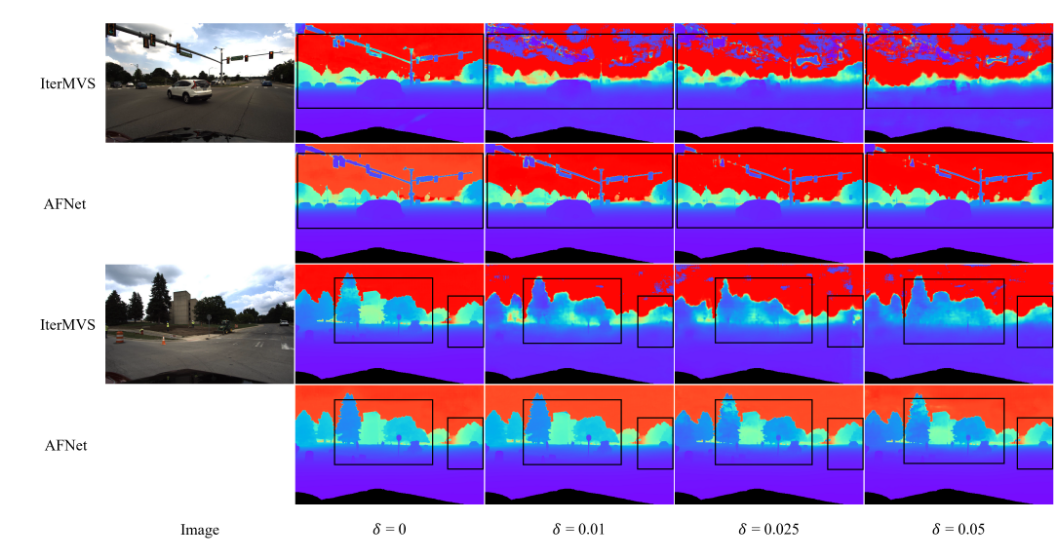

对noise pose 的鲁棒性