NVDS+: Towards Efficient and Versatile Neural Stabilizer for Video Depth Estimation

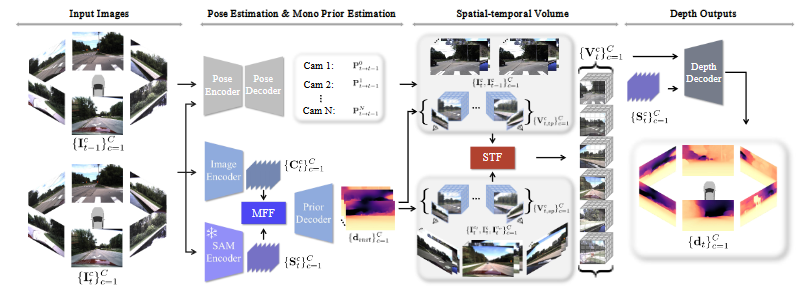

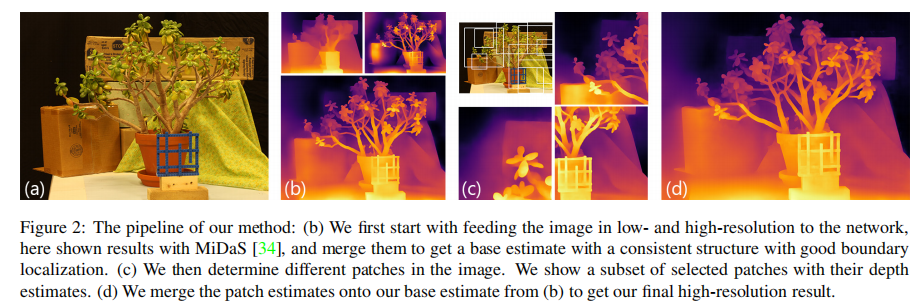

整体网络结构与NVDS保持一致

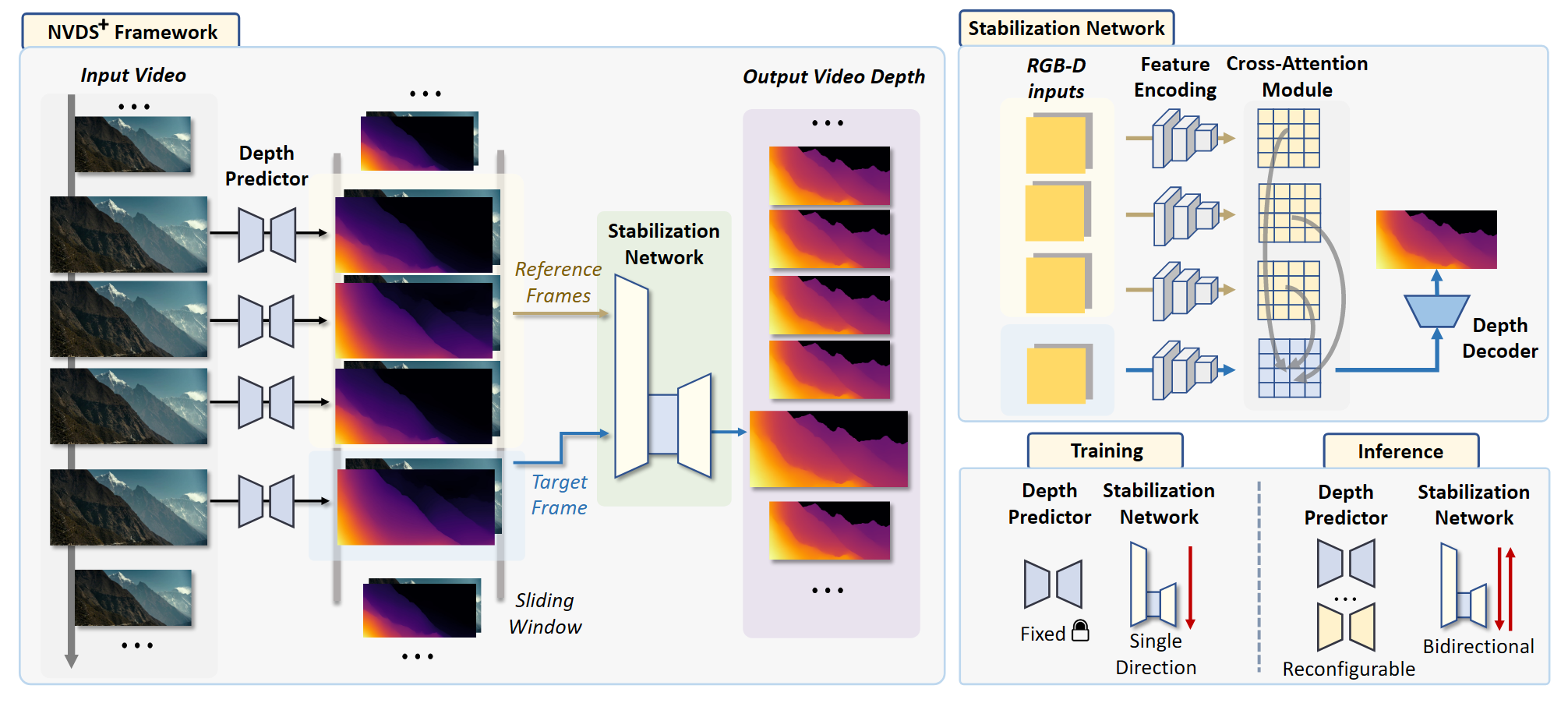

稳定网络

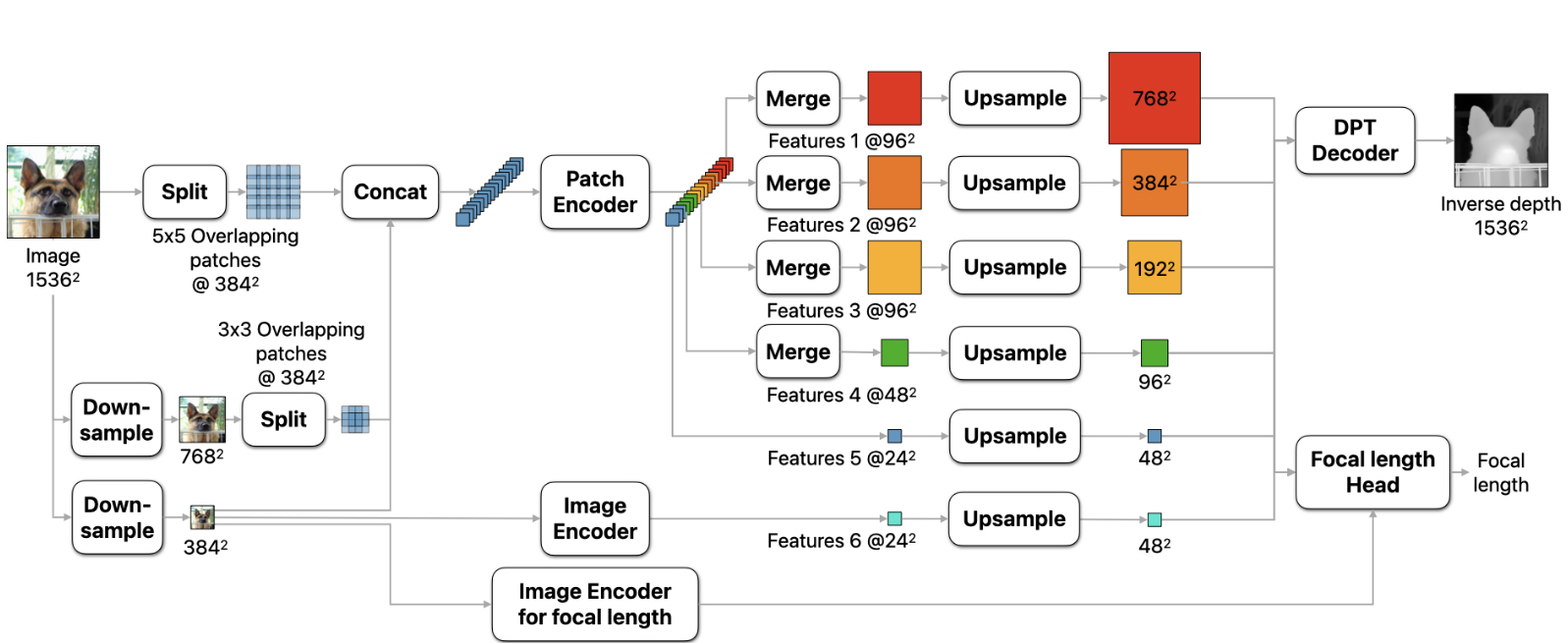

深度感知特征编码

对于一个滑动窗口中的一组初始深度图 $F^{norm}_i={F_1,F_2,F_3,F_4}$ ,其归一化的方式为:

将归一化后的深度图与RGB图像连接形成RGBD序列,通过transformer backbone编码成深度感知的特征图

交叉注意力模块

目标帧的特征图中的像素作为query,keys和values是从参考帧中生成的。

采用了patch merging的方法,并将交叉注意力机制限制在局部窗口内,减小计算开销。

用 $T$ 表示目标帧的深度感知特征,$R_1,R_2,R_3$ 分别表示三个参考帧的特征。则将 $T$ 分为没有重叠的7×7的patch,每一个patch都融合成一个token $t$ ,对于每一个token,对$R_1,R_2,R_3$ 进行局部窗口的池化,并将池化的结果堆叠为 $R_p$ ,则交叉注意力的计算方法为:

最后用特征融合模块,将深度感知特征与交叉注意力优化特征相融合,经过深度解码器得到最终预测结果。

稳定网络的训练(the same as NVDS)

训练损失函数:

采用基于光流的warping损失监督时序一致性:

双向推理(the same as NVDS)

采用后三帧与前三帧作为参考帧的稳定过程分别表示为:

双向的预测结果表示为:

双向推理的策略仍会造成一定的延迟,所以这是一个可选项,仅采用前向的预测也能够得到较好的结果。

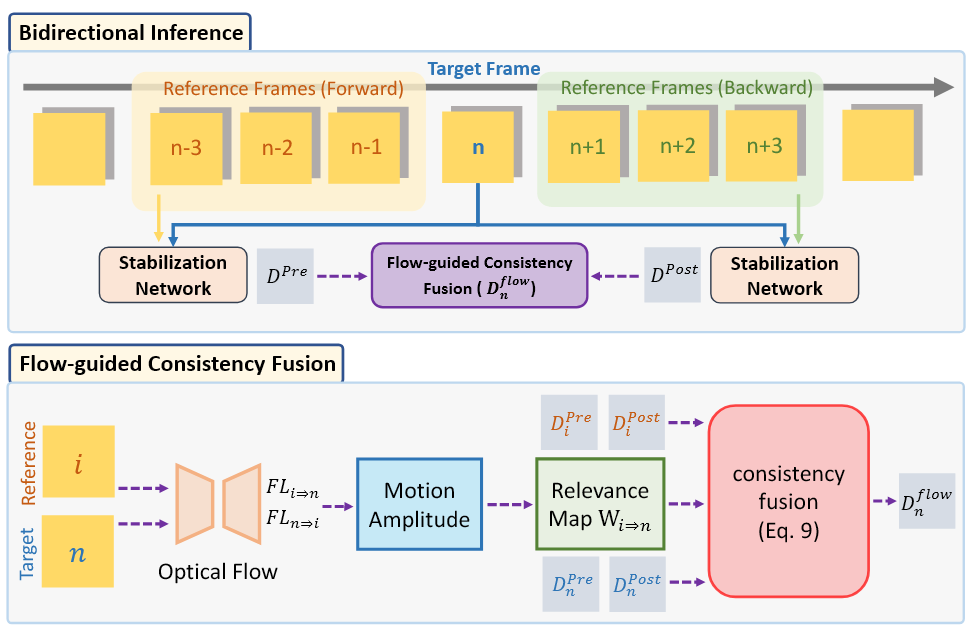

光流引导的一致性融合

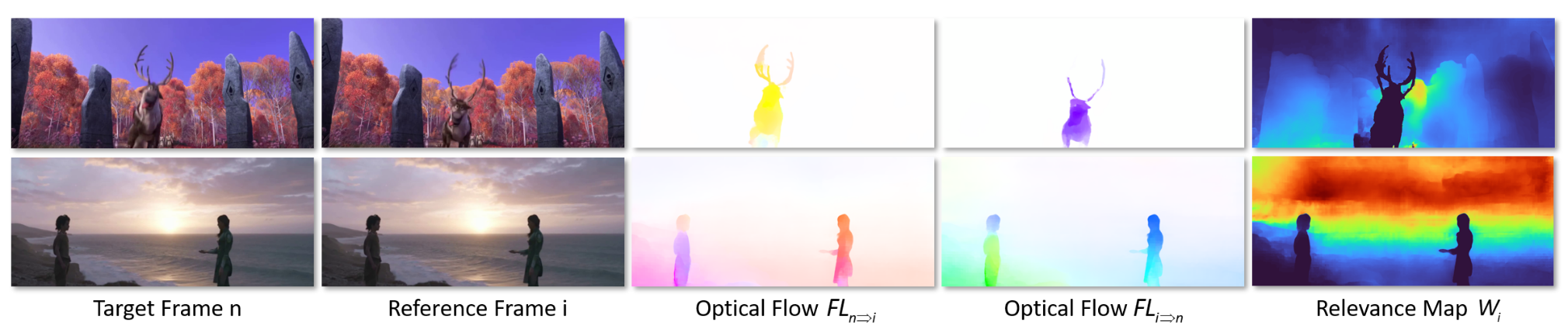

对于双向预测结果的融合采用自适应的权重系数会更加的合理,因为相对于目标帧有较大运动的帧或像素往往和最终目标深度的关系更小。因此采用光流引导的一致性融合策略。

计算参考帧和目标帧之间的光流,然后通过范数来表示帧之间的运动幅度,且运动幅度大的像素与目标帧对应像素的相关性就越小,因此,逐像素的自适应相关图表示为:

则最终光流引导的一致性融合后的深度表示为:

NVDS+实时模型与系列模型

Large模型能够取得最好的空间精度与时间一致性,Small模型可以用于实时处理。

Small模型的构建方法:使用轻量化的基于attention的骨干网络来编码深度感知特征,然后利用模型剪枝的方法增强其效率。

拓展至视频语义分割

将RGB和单通道的标签预测连接在一起作为稳定网络的输入,省略归一化操作,稳定网络的输出通道调整为代表类别数的通道,应用语义分割的decoder获得输出,并采用交叉熵损失进行监督。然后在预测的概率上采用双向推理与光流引导的一致性融合。

采用单通道的标签预测,而不采用标签概率分布作为输入的原因:概率分布有C个channel,会增加计算开销。且不同的数据集和场景,C是不一样的。