SSD:Stealing Stable Diffusion Prior for Robust Monocular Depth Estimation

背景

现有的MDE方法在标准的环境下(例如晴天)表现的很好,但是在一些具有挑战性的条件下效果会变得很差,这主要是由于一些关键的假设失效了,例如光度一致性假设,同时也没有可靠的ground truth包含这些场景。

现有的一些鲁棒的解决方案

基于模型的方法

这一方法通过修改网络结构来增强模型处理各种条件的能力

缺点:网络模型过于复杂,不能够适应各种环境

基于数据的方法

利用域自适应或其他模态的数据来增强图像信号

缺点:缺乏高质量的数据,需要后处理

方法

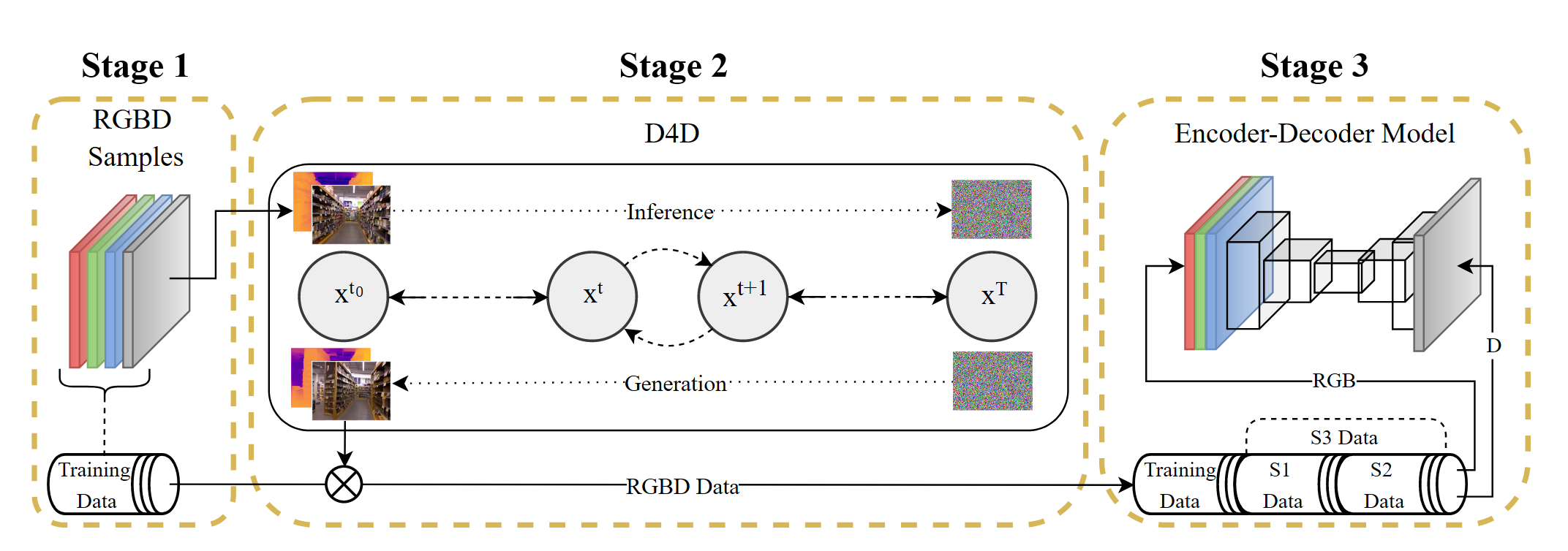

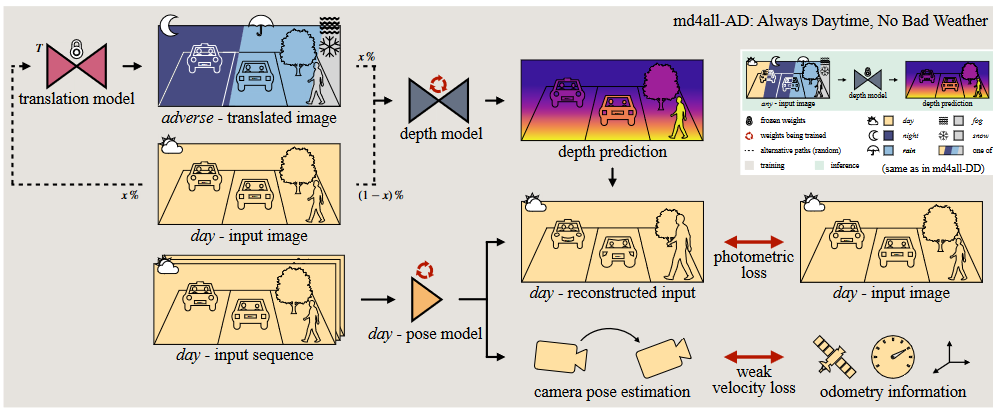

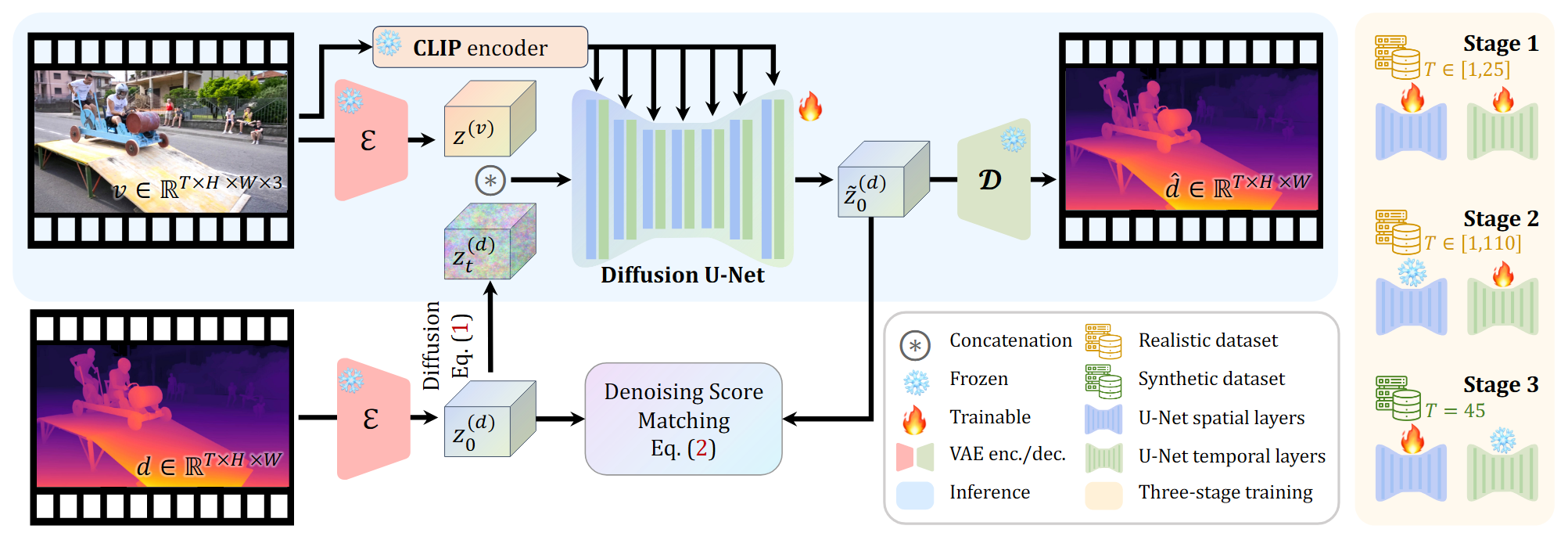

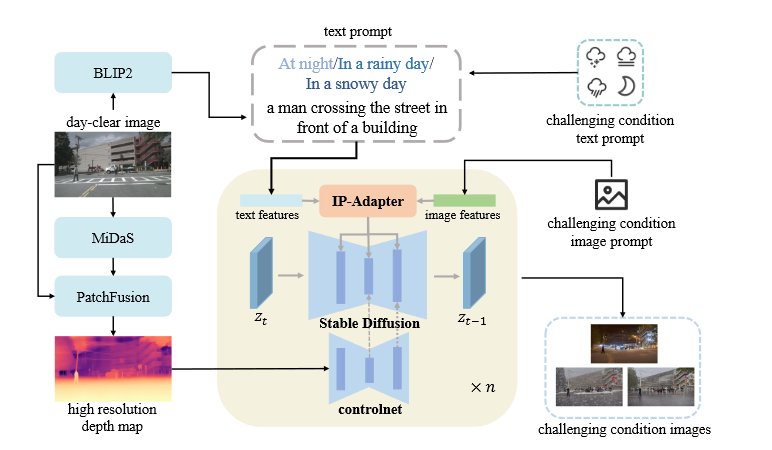

Generative Diffusion Model-based Translation

生成在深度方面与白天清晰图像非常相似的训练样本

- BILP2:获取场景描述符,保留图像内容信息

- ControlNet d2i:保持近似深度一致性

- MiDas:获取初始深度图

- PatchFusion:获得高分辨率的深度图

- text prompt=BILP2 场景描述符+challenging condition text prompt

- image prompt:用于风格转换

- IPAdapter:合并text prompts和image prompts

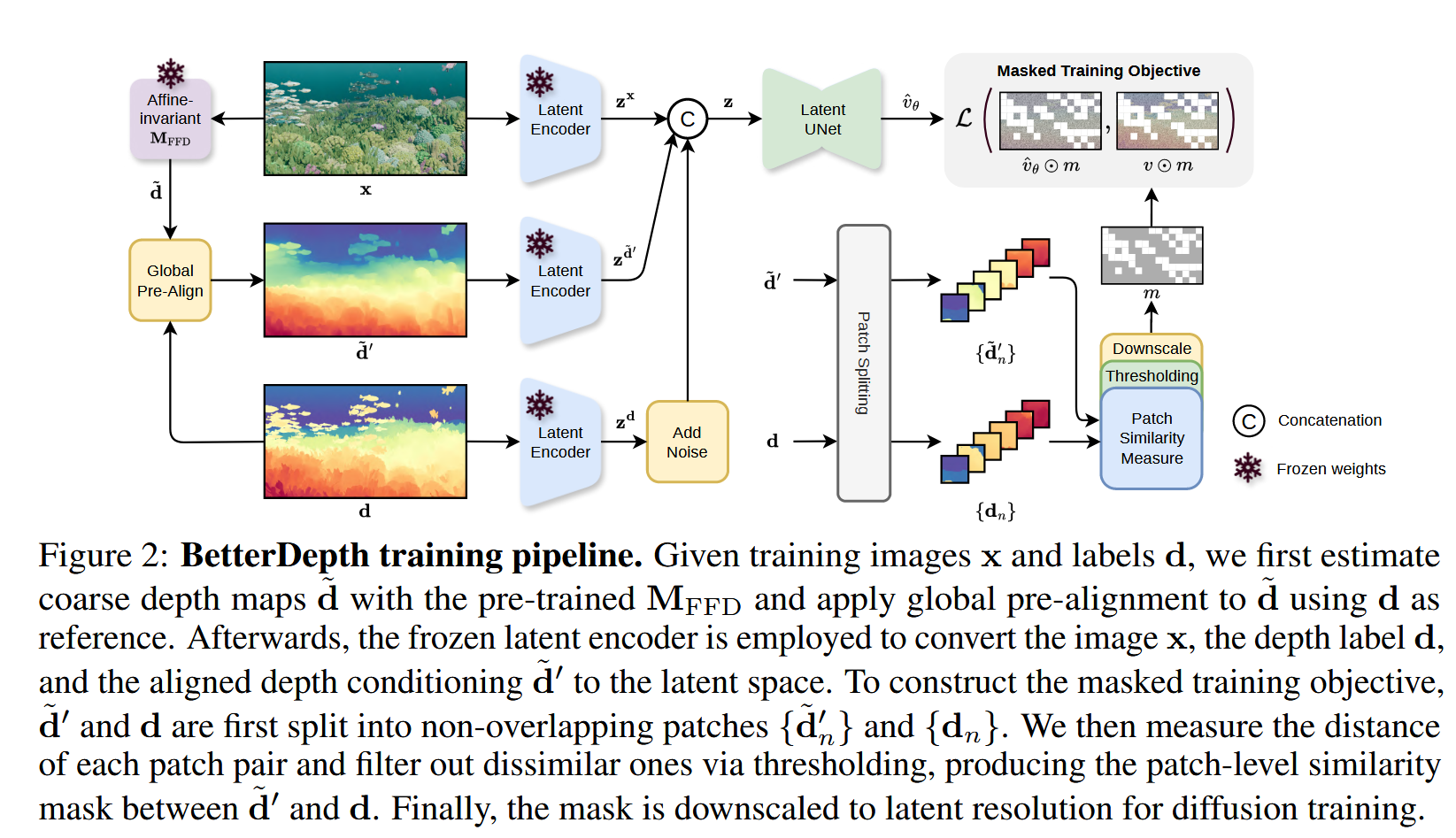

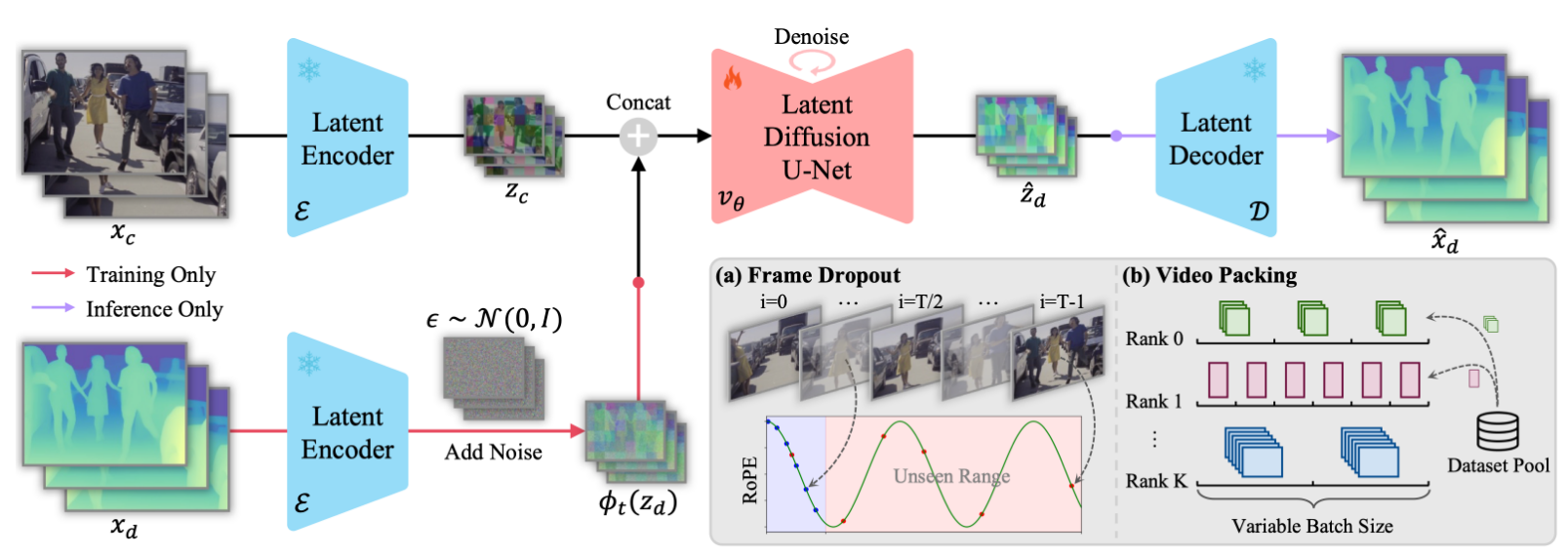

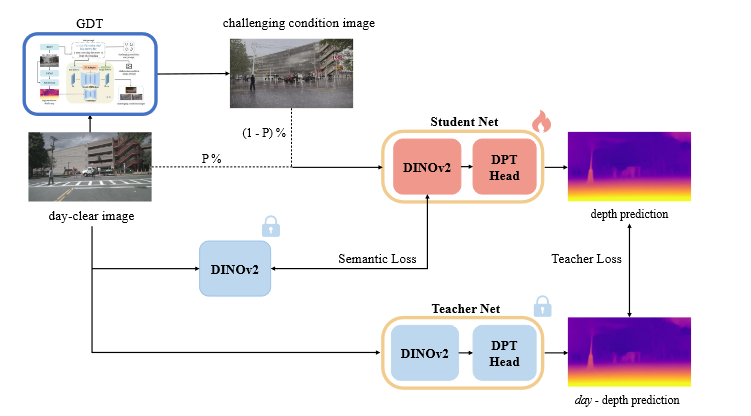

Stealing Stable Diffusion Prior

DINOv2作为encoder用于提取鲁棒的图像特征

自训练策略

在白天清晰的样本上训练教师网络,随后训练学生网络

训练学生网络时,P %的概率使用day-clear image,1-P%的概率使用challenging condition image

损失函数

教师Loss:在计算蒸馏损失的时候mask掉教师模型预测的不合理的深度值

利用PoseNet估计相机位姿,使用相邻帧重建当前帧

mask:对比教师模型和学生模型的光度误差

语义对齐Loss