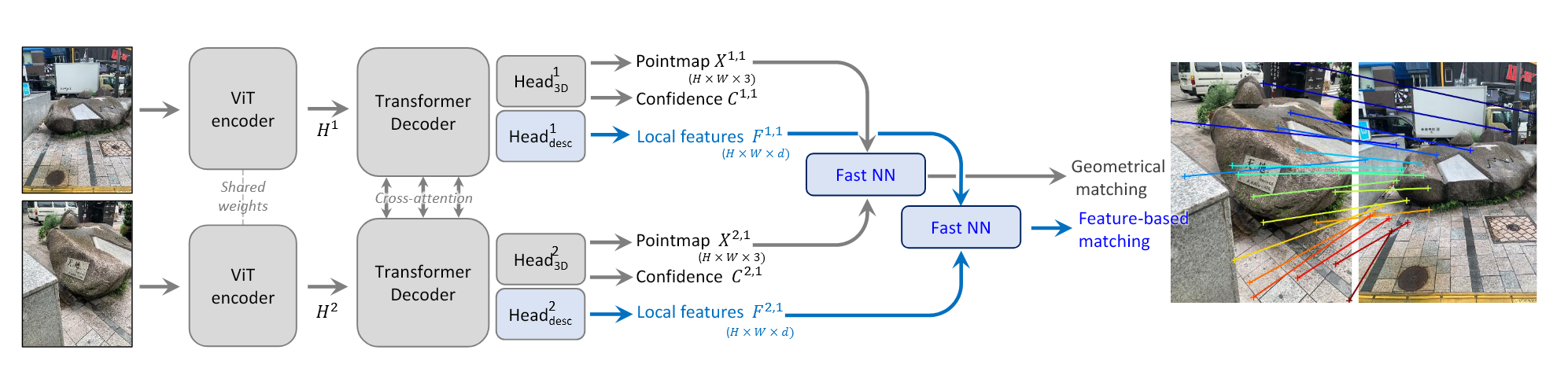

Grounding Image Matching in 3D with MASt3R

问题描述给定两张图像 $I^1$ 和 $I^2$ ,分别由未知参数的相机 $C^1$ 和 $C^2$ 采集,恢复出一组像素对应点 ${(i,j)}$ Method 由于gt pointmaps是metric的,所以为了得到metric的预测,将原本的nomalize的因子设置为 $z:= \hat{z}$ Matching prediction head and loss回归的方法固有地会受到噪声地影响,且DUSt3R没有显式地针对matching任务做训练。 Matching head D^{1}=\mathrm{H e a d}_{\mathrm{d e s c}}^{1} ( [ H^{1}, H^{\prime1} ] ), \tag{8} D^{2}=\mathrm{H e a d}_{\mathrm{d e s c}}^{2} ( [ H^{2}, H^{\prime2} ] ). \tag{9}Head是一个简单的两层MLP以及非线性GELU激活函数,最后,将每个局部feature 归一化。 Matching objective 一张图像中的每一个local...

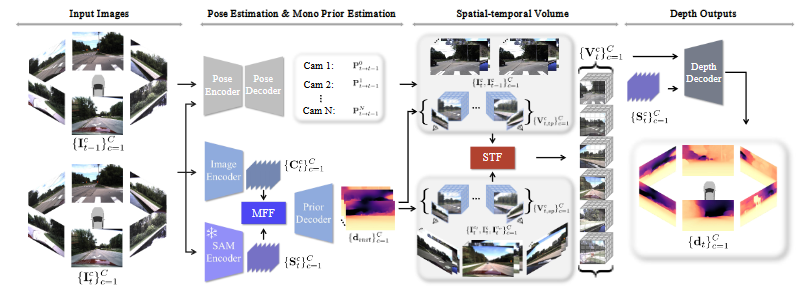

M²Depth: Self-supervised Two-Frame Multi-camera Metric Depth Estimation

\mathbf{P}_{t \to t-1}=( \mathbf{T}^{0} )^{-1} \mathbf{P}_{t \to t-1}^{0} \mathbf{T}^{0}MFF STF Depth Decoder Adaptive Depth Sample \mathbf{d}_{\operatorname* {m i n}} ( \mathbf{p} )=\mathbf{d}_{\operatorname* {i n i t}} ( \mathbf{p} ) \div( 1+\alpha) \mathbf{d}_{\operatorname* {max}} ( \mathbf{p} )=\mathbf{d}_{\operatorname* {i n i t}} ( \mathbf{p} ) \times( 1+\alpha)

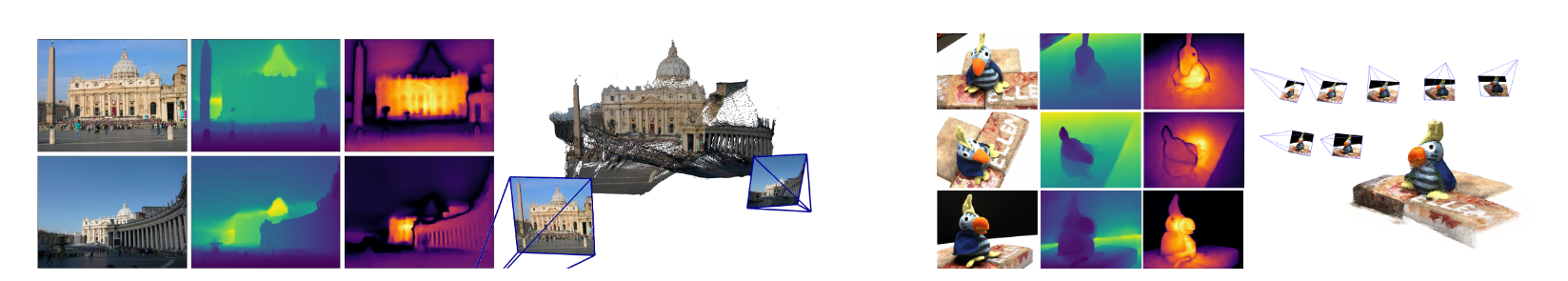

DUSt3R: Geometric 3D Vision Made Easy

相关概念Pointmap将三维点的稠密二维场表示为pointmap $X \in\mathbb{R}^{W \times H \times3}$ ,对应分辨率为$W×H$ 的RGB图像 $I$,$X$描述了图像像素和三维场景点之间的一一对应关系。 假设每一条相机光线只会击中一个三维点,即忽略半透明表面的情况 Cameras and scene给定相机内参矩阵$K \in\mathbb{R}^{3 \times3}$ ,pointmap就能够根据给定的ground-truth 深度图$D \in\mathbb{R}^{W \times H}$ 获得: X_{i, j}=K^{-1} D_{i, j} \left[ i, j, 1 \right]^{\top}$X^{n,m}$表示相机$n$的pointmap $X^n$在相机$m$坐标系中的表示: X^{n, m}=P_{m} P_{n}^{-1} h \left( X^{n} \right) \tag{1}其中$P{m}, P{n} \in\mathbb{R}^{3 \times4}$ 是世界坐标系到相机坐标系的位姿,$h...

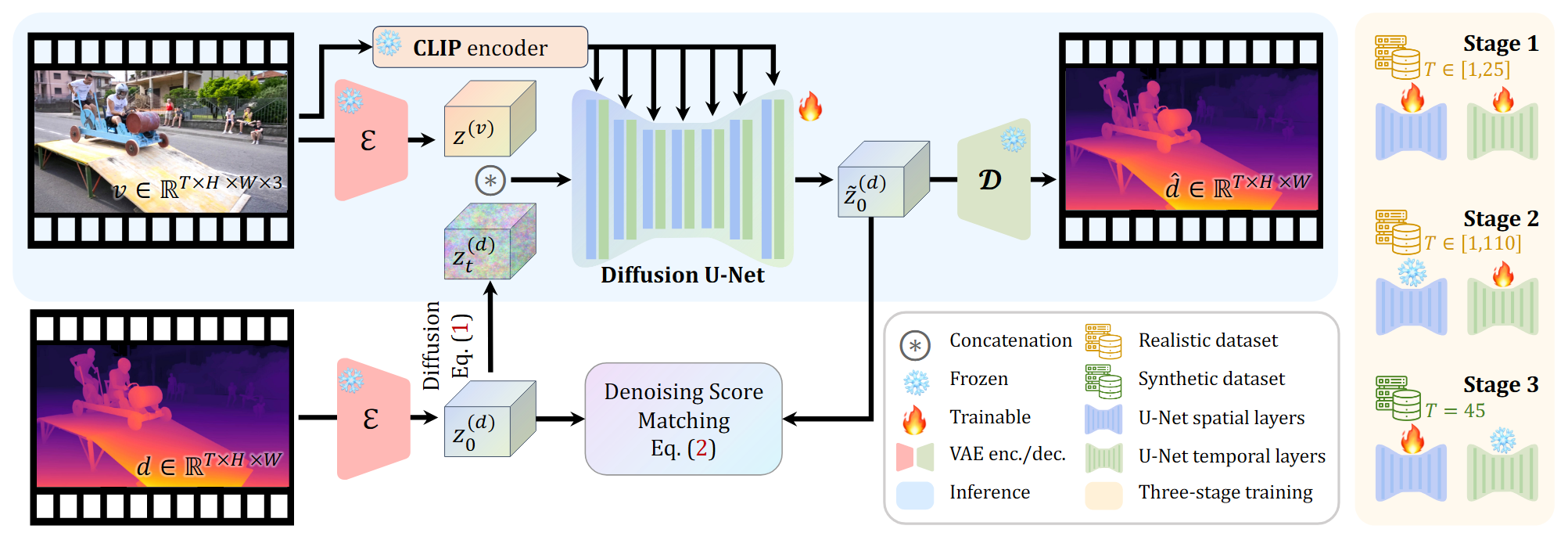

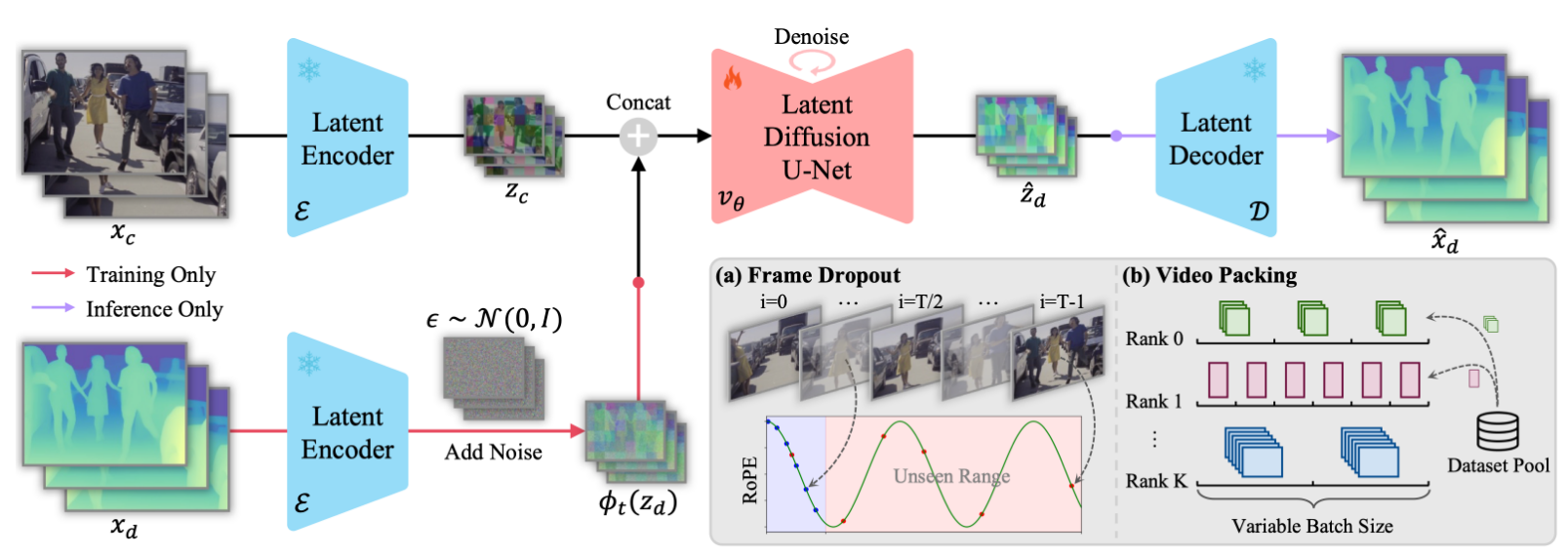

DepthCrafter

方法 将视频深度估计定义为一个条件扩散生成问题,对条件分布 $p({d}|v)$ 进行建模 采用成对的真实与合成数据集对网络进行三阶段的训练 对长序列进行分段估计并无缝拼接 Stable video diffusion model \mathbf{x}_t = \mathbf{x}_0+\sigma_t^2\epsilon,\quad \epsilon\sim \mathcal{N}(0, \mathbf{I})\tag{1} \mathbb{E}_{\mathbf{x}_t \sim p(\mathbf{x};\sigma_t),\sigma_t \sim p(\sigma)} \left[ \lambda_{\sigma_t} \left\|D_{\theta}(\mathbf{x}_t; \sigma_t; c) - \mathbf{x}_0 \right\|^2_2 \right] \quad \tag{2} D_\theta (\mathbf{x}_t; \sigma_t; \mathbf{c})...

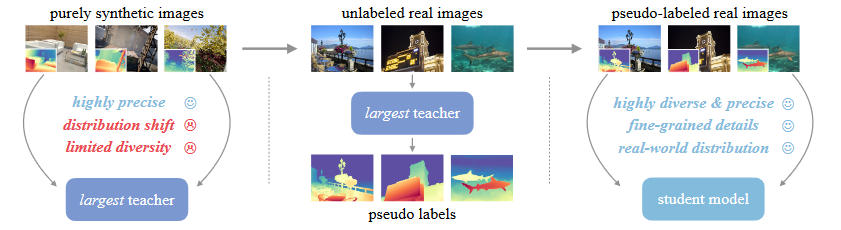

Depth Anything v2

三个关键方法:1)将所有有标签的真实图像更换为合成图像 2)增强了教师模型的capacity 3)通过大规模伪标签真实图像对学生模型进行训练 真实标签数据的缺点:1)标签噪声:传感器固有的缺点、透明等场景 2)忽略的细节:边缘、洞 导致错误的估计,过度平滑的估计 合成数据的局限性:1)合成图像与真实图像之间的分布偏移 真实图像包含更多随机性,合成图像场景的布置较为有序。 2)所覆盖的场景有限,难以与真实世界的场景相匹敌 大规模无标签真实图像的作用:1)缩小合成图像与真实场景之间的领域差异 2)增大所覆盖的场景范围 3)知识迁移 sparse的gt在评估的时候真的会影响指标的可靠性么? 能否直接训练或者使用一个强大的metric depth网络来生成metric的伪标签,从而使得学生模型能够具备metric depth预测能力?

DEPTH ANY VIDEO WITH SCALABLE SYNTHETIC DATA

构建合成视频数据集在不同的虚拟环境中,利用synthetic engines获取深度信息,构建了一个包含40000个视频切片的数据集,涵盖室内外场景。 在部分的图像和深度图之间可能存在不对齐的现象,首先采用 scene cut 方法,根据显著颜色变化检测场景的转变,然后用深度模型去滤除掉那些指标低的视频序列。 直接过滤指标低的视频序列可能会对导致过滤到一些网络没有见过的数据,因此,进一步使用 CLIP 来计算真实深度和预测深度之间的语义相似性。 最终方法是对每个视频序列均匀采样10帧,如果语义和深度的指标都低于预先定义的阈值,就滤除该片段 生成视频深度模型模型设计 训练和推理的过程与其他基于diffusion 的model保持一致。采用和Marigold一样的归一化方法。 \tilde{x}_{d}=\left( \frac{x_{d}-d_{2}} {d_{9 8}-d_{2}}-0. 5 \right) \times2, \tag{1}由于在时间维度上进行压缩会导致运动模糊伪影,所以只在空间维度上进行压缩。 将latent video和latent...

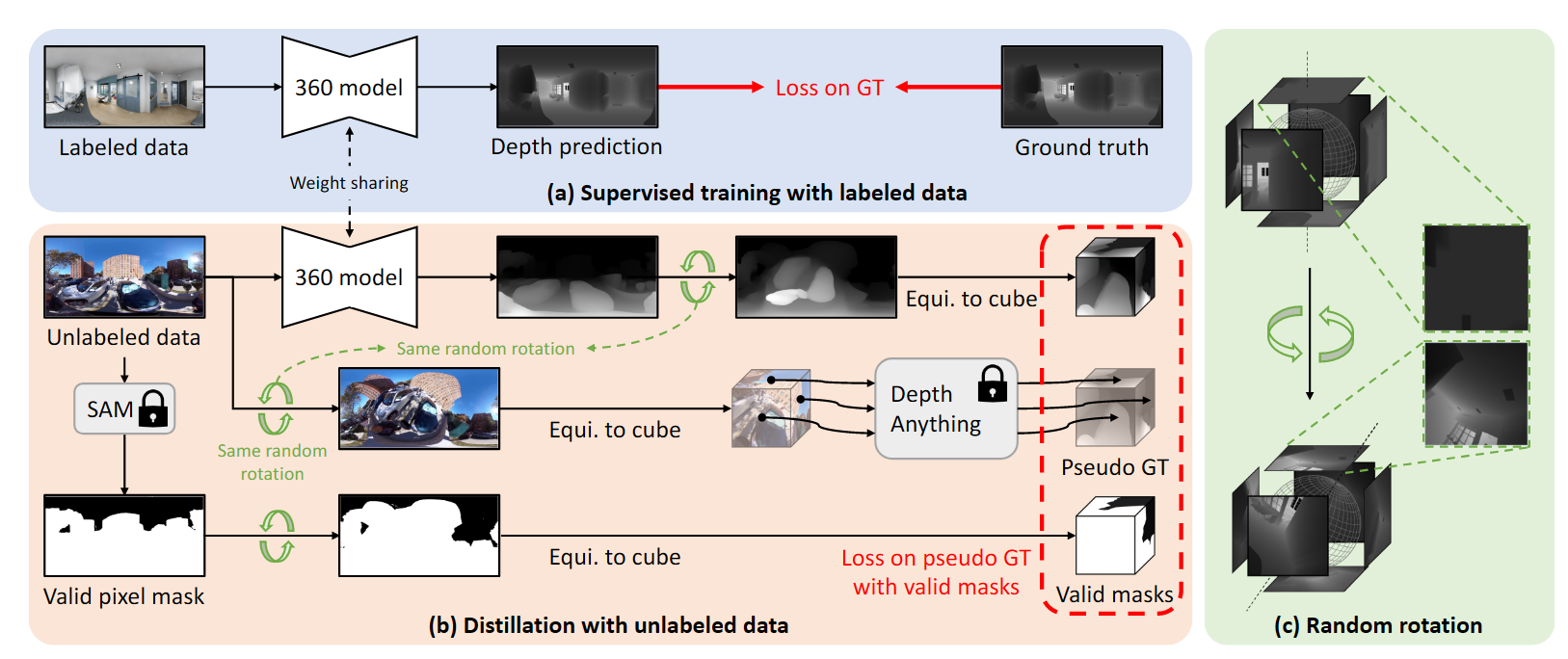

Depth Anywhere: Enhancing 360 Monocular Depth Estimation via Perspective Distillation and Unlabeled Data Augmentation

方法 数据清洗及合理数据掩码生成为了消除不合理像素对训练的影响,使用GroundingSAM将不合理的区域滤除。对于有效像素占比低于20%的图像也进行溢出。 教师模型对无标签图像使用立方体投影,然后用Depth Anything对投影后的patch进行预测,将360度模型的预测结果投影到立方体视图,再和Depth Anything的输出计算Loss。 随机旋转处理由于Depth Anything在立方体的每一个面上进行估计,缺乏对场景的综合理解,所以会出现伪影。 在等矩形坐标系下应用旋转矩阵: ( \hat{\theta}, \hat{\phi} )=\mathcal{R} \cdot( \theta, \phi). \tag{1}从等矩形到立方体投影,立方体每一个面的视场角等于90度,每一个面都能够看作一个焦距为$w/2$的透视相机,所有的面共用世界坐标系中的中心点。因此每一个相机的外参矩阵能够用一个旋转矩阵定义,则每个面上的像素表示为: p=K \cdot R_{i}^{T} \cdot q, \tag{2} q=\left[ \begin{matrix} q_{x}...

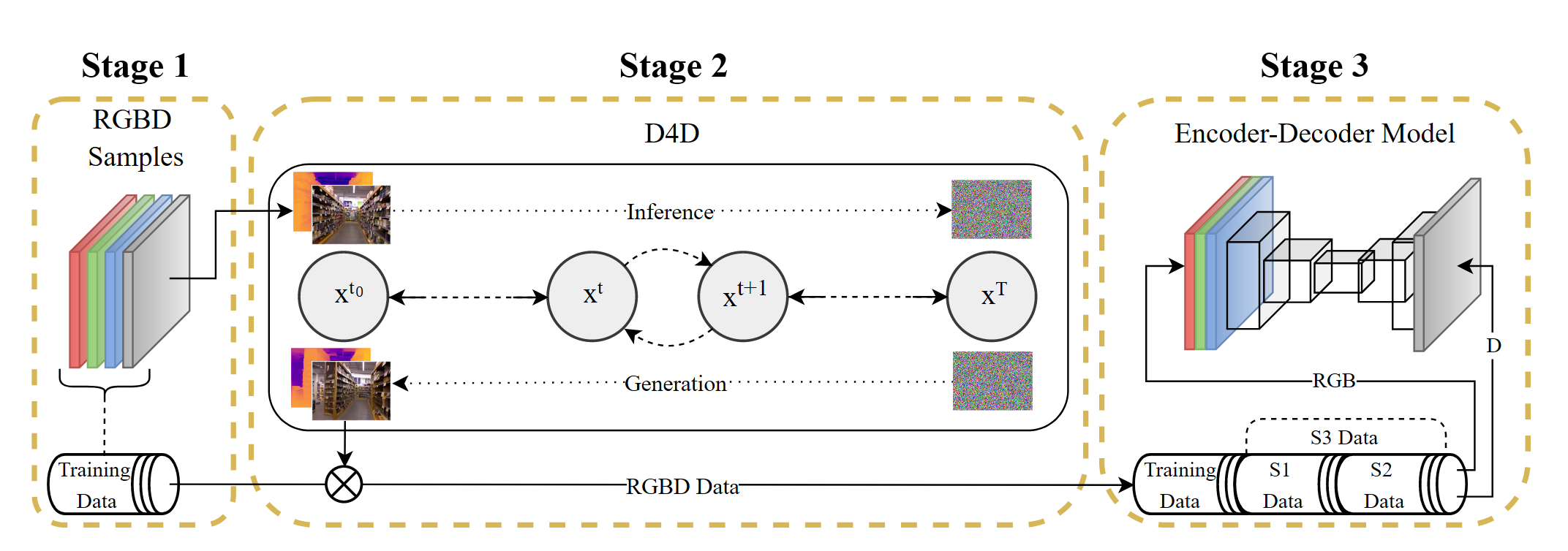

D4D: An RGBD diffusion model to boost monocular depth estimation

方法阶段一对NYU和KITTI中的RGBD样本进行预处理,进行归一化以及rescale,分辨率跟第三阶段所采用的model有关 阶段二第二阶段对输入的RGBD进行前向和后向操作训练网络,同时通过S1和S2两种不同的训练配置,得到不同的生成数据,其中$S1$使用$L1$ loss,$β$策略采用线性策略,$S2$使用$L2$ loss,$β$采用余弦策略 S 1 : L 1=\frac{1} {| \mathcal{P} |} \sum_{p \in\mathcal{P}} | | x_{p}-y_{p} | |_{1}, \; \; \beta=l i n e a r \tag{3} S 2 : L 2=\frac{1} {| \mathcal{P} |} \sum_{p \in\mathcal{P}} | | x_{p}-y_{p} | |_{2}^{2}, \; \; \beta=c o s i n e \tag{4}最终得到的$S3$就是$S1$和$S2$的并集 S 3=( s 1 \cup s 2 ) \; w h e r e \begin{cases} S 1...

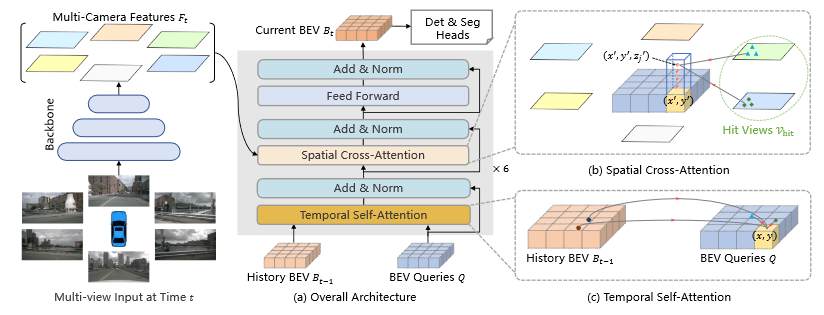

BEVFormer

BEV Queries Q∈R^{H×W×C}where H, W are the spatial shape of the BEV plane. Each grid cell in the BEV plane corresponds to a real-world size of s meters. The center of BEV features corresponds to the position of the ego car by default. Spatial Cross-Attention \mathrm{S C A} ( Q_{p}, F_{t} )=\frac{1} {| \mathcal{V}_{\mathrm{h i t}} |} \sum_{i \in\mathcal{V}_{\mathrm{h i t}}} \sum_{j=1}^{N_{\mathrm{h i t}}} \mathrm{D e f o r m A t t n} ( Q_{p}, \mathcal{P} ( p, i, j ), F_{t}^{i} ), x^{\prime}...

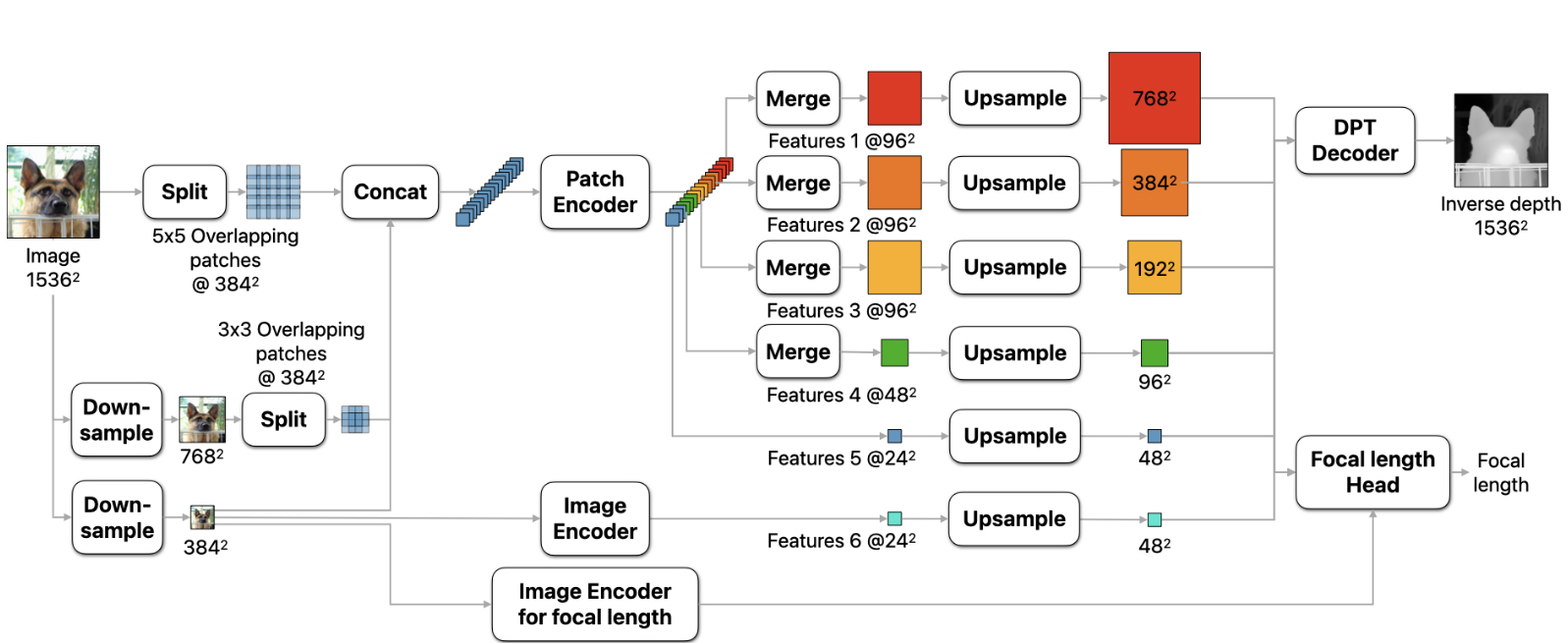

DEPTH PRO: SHARP MONOCULAR METRIC DEPTH IN LESS THAN A SECOND

思路:在不同的尺度提取patches,对patches应用ViT encoders,将patches 的预测结果融合成一个单独的高分辨率的稠密估计。 方法 1.相对于可变分辨率的方法,将输入分辨率固定为了1536×1536,保证了足够大的感受野,防止了out-of-memory的问题。使用普通的ViT encoder,能够利用多种预训练ViT的主干网络。 2.将输入图像分成5×5个分辨率为384×384的重叠patch,下采样至786×786后分成3×3个重叠的patch。将patch链接后输入patch encoder,每一个patch得到分辨率为24×24的feature。在精细的尺度上,进一步提取中间特征。得到特征之后将特征patches融合成maps输入decoder。 Sharp 单目深度估计训练目标网络预测的输出为canonical inverse depth,然后通过视场角转换为metric depth D_m=\frac{f_{px}}{wC}对于metric datasets,使用MAE...